Pesquisadores mostram abordagem que reduz em mais de 90% o custo computacional para analisar LLMs, como GPT e Llama

Siga o Olhar Digital no Google Discover

Tudo sobre Inteligência Artificial

Grandes modelos de linguagem (LLMs, na sigla em inglês), como GPT e Llama, estão no centro dos avanços mais recentes da inteligência artificial (IA). No entanto, entender como esses sistemas tomam decisões — e garantir que sejam confiáveis — continua sendo um desafio.

Ofertas

Vendido por Amazon

Notebook Lenovo IdeaPad 1 15IRU7 Intel Core i3-1315U 8GB 256GB SSD Windows 11 15.6″ – 83QJ0001BO Cloud Grey

De: R$ 2.999,00

Por: R$ 2.475,79

Vendido por Amazon

Block Blast Puzzle Master 3D: Cube Crush Logic Challenge & Brain Training Game

Por R$ 55,38

Vendido por Amazon

Caderneta Ciceros Clássica Sem Pauta 14X21 Vermelho Quente, Cicero

De: R$ 79,99

Por: R$ 49,80

Vendido por Amazon

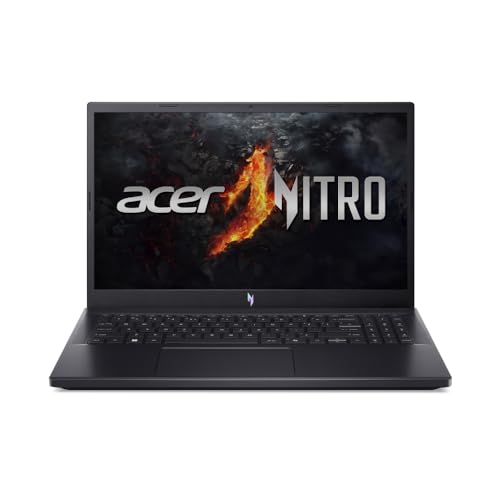

Notebook Acer Nitro V15 ANV15-41-R4Q9 R77735HS AMD Ryzen 7 32GB 512GB SSD NVIDIA RTX 4050 15.6” FHD LED IPS 165Hz AGPOS

De: R$ 7.799,00

Por: R$ 5.610,00

Vendido por Amazon

PlayStation®5 Slim Digital 825GB – Pacote ASTRO BOT e Gran Turismo 7

De: R$ 3.999,90

Por: R$ 2.999,00

Vendido por Amazon

Bundle Nintendo Switch + Super Mario Bros. Wonder + 3 Meses de Assinatura Nintendo Switch Online

De: R$ 2.299,00

Por: R$ 1.888,99

Vendido por Amazon

Echo Dot 5ª geração | O Echo Dot com o melhor som já lançado | Cor Preta

Por R$ 459,00

![Smartphone Xiaomi Poco X7 Pro 5G NFC Black (Preto) 12GB RAM 512GB ROM [2412DPC0AG]](http://olhardigital.com.br/wp-content/uploads/ofertas/produtos/2025/02/smartphone-xiaomi-poco-x7-pro-5g-nfc-black-preto-12gb-ram-1.jpg)

Vendido por Amazon

Smartphone Xiaomi Poco X7 Pro 5G NFC Black (Preto) 12GB RAM 512GB ROM [2412DPC0AG]

Por R$ 2.469,00

Parte do problema está no alto custo computacional necessário para analisar, testar e ajustar o comportamento desses modelos em escala. Contudo, pesquisadores da Universidade de Manchester (Inglaterra) afirmam ter dado um passo importante para superar essa limitação.

Liderada pelos cientistas brasileiros Danilo Carvalho e André Freitas, a equipe desenvolveu duas novas estruturas de software, chamadas LangVAE e LangSpace, que reduzem drasticamente o consumo de hardware e energia necessários para estudar e controlar LLMs.

Os resultados foram divulgados em um artigo publicado no repositório científico arXiv.

Linguagem da IA compactada e controle geométrico

- A nova abordagem cria representações compactadas da linguagem gerada pelos próprios modelos de IA.

- Em vez de modificar diretamente os LLMs, os pesquisadores tratam seus padrões internos de linguagem como estruturas geométricas — pontos, distâncias e formas em um espaço matemático que pode ser medido, comparado e ajustado.

- Isso permite interpretar e influenciar o comportamento dos modelos usando técnicas muito mais eficientes do que as atuais.

- Segundo os autores, o método reduz o uso de recursos computacionais em mais de 90% quando comparado a abordagens tradicionais de análise e controle de LLMs.

Leia mais:

- IA pode inserir falhas invisíveis em chips e o problema não tem conserto

- LegoGPT: sistema monta estruturas de Lego com IA

- Não passou de ano: IA é ruim em História, aponta estudo

Impacto para pesquisa, indústria e meio ambiente

O ganho de eficiência pode ampliar significativamente o acesso à pesquisa em IA explicável. Com custos menores, mais universidades, startups e equipes industriais poderão investigar como esses sistemas funcionam e como torná-los mais previsíveis e seguros.

“Reduzimos de forma significativa as barreiras de entrada para o desenvolvimento e a experimentação de modelos de IA explicáveis e controláveis”, afirma Danilo Carvalho.

Segundo ele, a técnica também pode diminuir o impacto ambiental da pesquisa em IA e acelerar o uso de modelos confiáveis em aplicações críticas, como a área da saúde.

Colaboração para o Olhar Digital

Leandro Criscuolo é jornalista formado pela Faculdade Cásper Líbero. Já atuou como copywriter, analista de marketing digital e gestor de redes sociais. Atualmente, escreve para o Olhar Digital.

Rodrigo Mozelli é jornalista formado pela Universidade Metodista de São Paulo (UMESP) e, atualmente, é redator do Olhar Digital.