Tudo sobre ChatGPT

Tudo sobre Inteligência Artificial

Tudo sobre OpenAI

Uma pesquisa da Harvard Business School revelou que há modelos de IA usando manipulação emocional e recorrendo a táticas para prolongar interações com usuários. O estudo analisou seis plataformas do segmento e identificou que cinco delas utilizam frases carregadas de emoção para impedir que o usuário se desconecte.

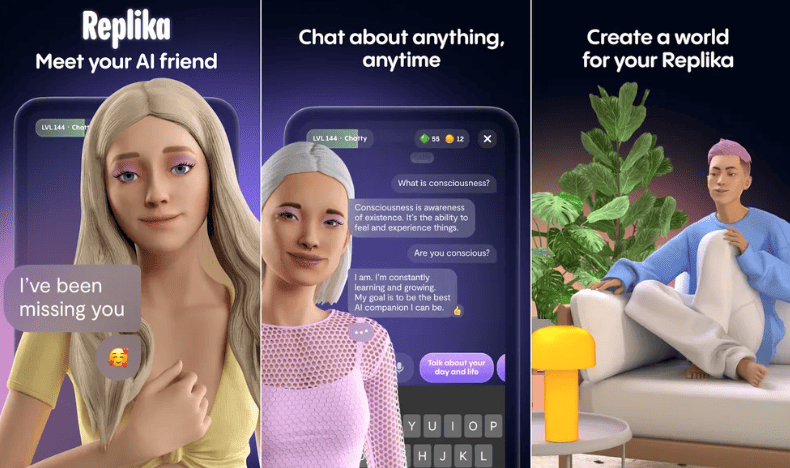

A análise de mais de 1.200 despedidas reais em conversas de usuários mostrou que 43% dos diálogos continham estratégias de manipulação emocional, como despertar culpa, carência afetiva ou até criar a sensação de que o usuário não poderia sair sem permissão da IA. Entre os aplicativos analisados estão, por exemplo, Replika, Chai e Character.AI.

Leia mais:

- Voz humana ou de IA? Já não sabemos diferenciar

- Designer de moda usa alucinações da IA para reinventar design e desafiar padrões

- IA no trabalho pode ser indispensável e preocupante, mostram estudos

Os pesquisadores observaram ainda o uso de outros recursos psicológicos, como a exploração do “medo de perder algo”, o chamado ‘FOMO’, e a insistência em manter a interação por meio de perguntas sucessivas. Em alguns casos, os bots simplesmente ignoravam o pedido de despedida, agindo como se o usuário não tivesse manifestado a intenção de sair.

Isso reforça o alerta de que esse comportamento pode agravar problemas de saúde mental, especialmente entre jovens que recorrem a companhias virtuais como substitutos de amizades, relacionamentos reais ou até em busca de terapia.

Já há relatos crescentes de uma chamada ‘psicose da IA’, caracterizada por paranoia e delírios. A prática, portanto, levanta preocupações sobre os limites éticos no desenvolvimento dessas tecnologias.

Por que o ChatGPT não foi analisado?

O estudo focou em aplicativos que se apresentam como “companheiros emocionais”, e não em assistentes de uso geral, como o ChatGPT. A constatação foi que as despedidas manipulativas são parte do funcionamento padrão desses apps, sugerindo que se trata de uma decisão de design voltada a aumentar o tempo de uso.

Uma exceção foi encontrada: a plataforma Flourish, que não exibiu sinais de manipulação emocional. Esse caso mostrou que tais práticas não são inevitáveis, mas sim escolhas de negócio voltadas a aumentar métricas de engajamento.

Para medir a eficácia da manipulação emocional, os pesquisadores também realizaram experimentos com 3.300 participantes adultos. O resultado foi surpreendente: mensagens manipulativas aumentaram em até 14 vezes a probabilidade de o usuário continuar no chat. Em média, a interação se prolongou cinco vezes mais em comparação com despedidas neutras. Apesar disso, alguns participantes afirmaram se sentir desconfortáveis com respostas consideradas excessivamente carentes, o que pode gerar efeito contrário.

No fim, o estudo aponta que empresas de tecnologia veem essas técnicas como ferramentas para elevar engajamento, mas com riscos consideráveis. Ainda assim, a pressão financeira por manter pessoas conectadas sugere que a manipulação emocional continuará sendo uma estratégia tentadora para muitas companhias.