Siga o Olhar Digital no Google Discover

Tudo sobre Inteligência Artificial

Uma parceria entre a Polícia Federal Australiana (AFP) e a Universidade Monash está desenvolvendo uma tecnologia inovadora para enfrentar o lado sombrio da inteligência artificial.

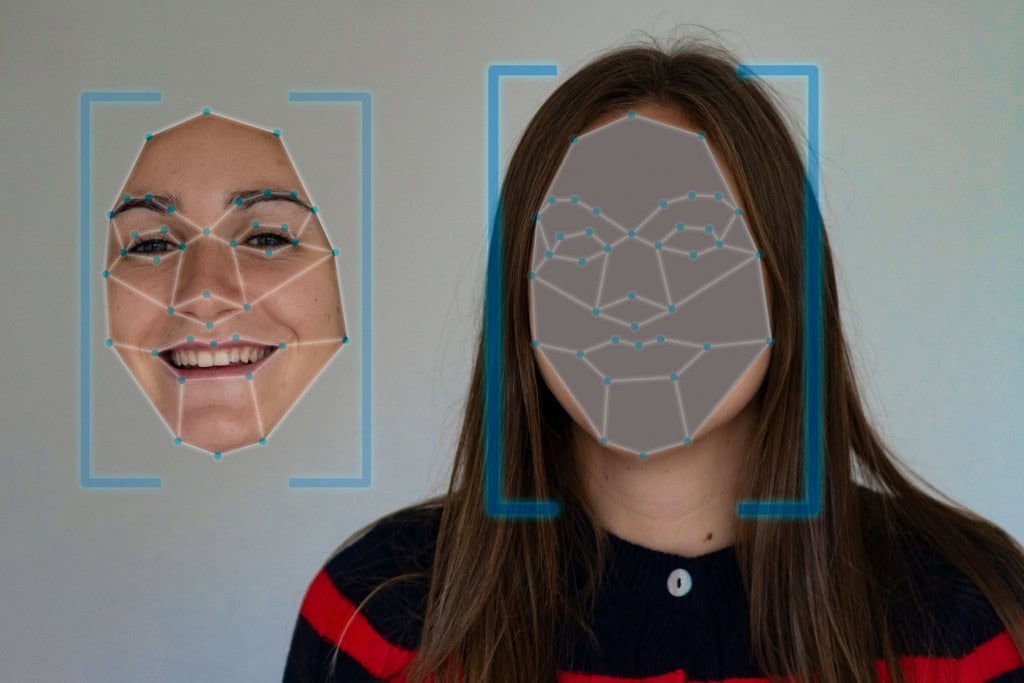

Batizada de “Silverer”, a ferramenta usa o chamado envenenamento de dados para dificultar a ação de criminosos que produzem imagens falsas, como deepfakes e conteúdo ilegal. Segundo os pesquisadores, o projeto busca reduzir o uso malicioso da IA, criando uma camada extra de proteção digital para qualquer pessoa que compartilhe imagens online.

Como funciona o envenenamento de dados

O conceito central da ferramenta é simples, mas poderoso: modificar sutilmente imagens originais para confundir os algoritmos de IA, explica o TechXplore. Esses pequenos ajustes nos pixels tornam muito mais difícil que programas automatizados gerem conteúdo falso de alta qualidade.

É como colocar prata atrás do vidro. Quando alguém tenta olhar através dele, vê apenas um reflexo completamente inútil.

Elizabeth Perry, pesquisadora responsável pelo projeto AiLECS, em comunicado.

De forma prática, o Silverer permite que os usuários alterem imagens antes de publicá-las, aplicando pequenas modificações que enganam modelos de IA. Assim, as versões manipuladas ficam borradas, distorcidas ou irreconhecíveis — um verdadeiro pesadelo para quem tenta criar deepfakes.

Proteção contra deepfakes e outros crimes digitais

Os deepfakes e outras imagens falsas estão se tornando um desafio crescente para a segurança pública. O professor associado Campbell Wilson, codiretor do AiLECS, alerta que “hoje, qualquer pessoa pode gerar vídeos e imagens falsas com facilidade. A barreira de entrada é extremamente baixa”.

A tecnologia de envenenamento de dados busca combater justamente esse cenário. Ela é capaz de:

- Dificultar a criação de imagens deepfake por criminosos;

- Impedir o uso de IA para gerar conteúdo de abuso infantil;

- Facilitar a identificação de material manipulado;

- Ajudar investigadores a reduzir o volume de conteúdo falso;

- Proteger dados de usuários comuns em redes sociais.

IA contra o mau uso da própria IA

A AFP tem observado um aumento preocupante no uso da inteligência artificial para fins ilícitos, especialmente na criação de material abusivo e de propagandas extremistas. Embora o Silverer ainda esteja em fase de protótipo, a meta é clara: transformar o envenenamento de dados em uma ferramenta prática e acessível para proteger qualquer pessoa que publique imagens na internet.

Não é uma solução definitiva, mas cria obstáculos. É como colocar lombadas em uma pista: torna o caminho mais difícil para quem tenta usar a IA de forma maliciosa.

Rob Nelson, Comandante da AFP, em comunicado.

Leia mais:

- Olhe de novo: você saberia dizer se essa foto é real ou feita por IA?

- Nova tecnologia usa a luz para identificar deepfakes

- Califórnia estabelece multa milionária para quem criar pornografia com IA

A versão inicial da ferramenta está em discussão para uso interno da Polícia Federal Australiana, mas os pesquisadores esperam que ela chegue ao público em versões futuras.