Tudo sobre Google

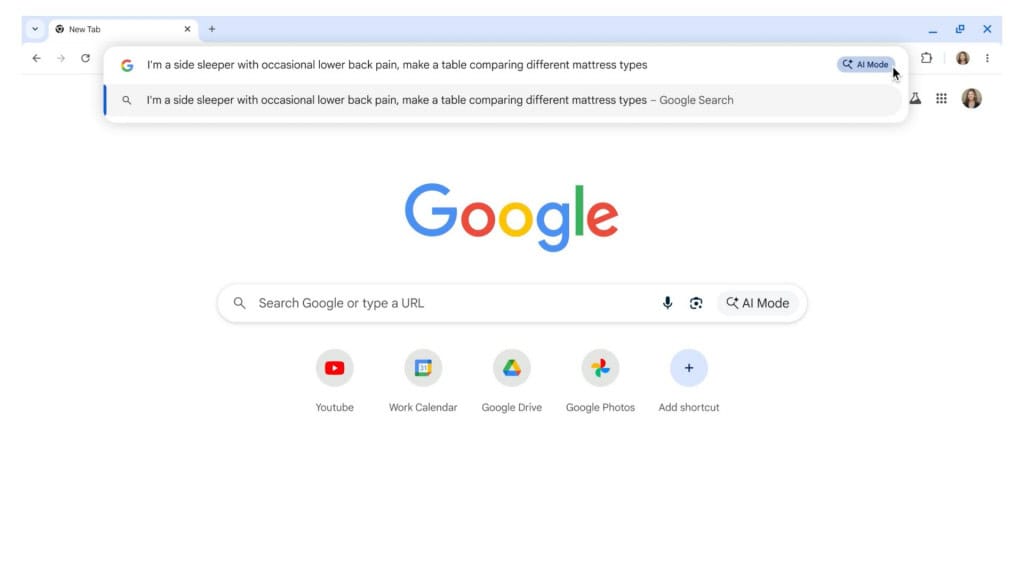

O Google realizou nas últimas semanas uma mudança significativa em seus resultados de busca, alterando a quantidade de resultados exibidos por página e impactando a forma como ferramentas de SEO registram as impressões. A modificação, que retira o parâmetro ‘&num=100’ que permitia ver até 100 resultados por página na pesquisa, gerou distorções nos dados de rastreamento e causou reações na comunidade digital, que já vem sendo bastante impactada pelos resultados gerados por IA.

Especialistas indicam que a alteração pode ter sido uma medida para tornar os dados mais precisos, mas também aumentou a dificuldade de acompanhamento de métricas por profissionais de SEO. A mudança silenciosa, mas impactante, afetou diretamente as ferramentas utilizadas por profissionais de SEO para rastrear e analisar o desempenho dos sites.

Leia mais:

- Google põe até R$ 170 mil na mesa para quem achar bugs em suas IAs

- Os 5 melhores recursos do Google Nano Banana para edição de imagem

- Audiência sobre monopólio do Google em publicidade chega ao fim

Como era e como ficou a visualização no Google?

Antes dessa alteração, era possível visualizar até 100 resultados por página, o que facilitava a análise de dados e ajudava ferramentas como SEMrush e Accuranker a medir a posição média dos sites. Contudo, com a mudança, o Google agora limita o número de resultados exibidos.

Essa modificação no algoritmo do Google dificultou a coleta de informações precisas sobre o desempenho de sites, especialmente para aquelas empresas que dependem de grandes volumes de dados para ajustar suas estratégias de SEO. Os dados de impressões também passaram a ser mais restritos, o que alterou as métricas de engajamento e visibilidade.

Para especialistas, a mudança tem grande impacto na dinâmica do ecossistema:

A remoção do parâmetro ‘&num=100’ pelo Google vai além do impacto técnico nas ferramentas de SEO, pois altera a dinâmica de acesso a resultados que alimentam sistemas como o ChatGPT e outros agentes de busca baseados em LLMs. Com menos resultados disponíveis por requisição e mais barreiras ao scraping – técnica que usa bots para extrair dados de sites – modelos que dependem de dados coletados da web passam a ter uma visão mais limitada e filtrada do conteúdo recente.

Já é possível observar efeitos práticos: o ChatGPT, por exemplo, tem citado com menor frequência fontes como o Reddit e fóruns de discussão em comparação ao mês anterior, reflexo da redução no acesso e indexação indireta desses conteúdos. Essa mudança reforça uma tendência clara de que o Google está estreitando o fluxo de dados livres da web, o que impacta não só o SEO tradicional, mas também a diversidade e representatividade das respostas geradas por IA.

Nicolas Silberstein Camara, cofundador e CTO da Firecrawl, startup especializada em estruturar dados da internet para alimentar sistemas de IA

O que pode explicar a mudança?

Por outro lado, essa modificação pode ser uma tentativa do Google de melhorar a qualidade dos dados, reduzindo a influência de bots que manipulavam as impressões e distorciam as métricas. As mudanças podem trazer mais precisão e refletir melhor o comportamento real dos usuários ao navegar nas páginas de busca.

Além disso, a alteração também afeta o uso de ferramentas de inteligência artificial que dependem de grandes volumes de resultados para gerar respostas mais completas. Com a nova limitação, essas ferramentas podem apresentar informações mais restritas, afetando sua capacidade de fornecer resultados robustos.

Embora a remoção desse parâmetro tenha causado transtornos imediatos, ela pode representar um movimento estratégico do Google em busca de maior precisão nos dados. Agora, profissionais de SEO precisam se adaptar a essas mudanças e encontrar novas maneiras de otimizar suas estratégias digitais.